EnCharge AI从隐形中脱颖而出,采用内存计算技术

这家初创公司正在兜售高效的人工智能计算,利用内存计算,简化与人工智能框架的集成。2022年12月21日作者:Chantelle Dubois

EnCharge AI最近宣布了一轮成功的a轮融资,以推进其AI硬件加速器,投资公司Anzu Partners、AlleyCorp、Scout Ventures、Silicon Catalyst Angels、Schams Ventures、E14 Fund和Alumini Ventures提供2170万美元的担保。

Encharge人工智能有望实现高效率,测试芯片可实现150 TOPS/W的8-b计算,与PyTorch和TF等流行的人工智能框架无缝软硬件集成,每瓦性能提高20倍,每美元性能提高14倍。

EnCharge AI创始人,从左到右依次为Kailash Gopalakrishnan博士、Echere Iroaga博士和Naveen Verma博士。

该公司最初是通过DARPA的2017年电子复兴倡议(ERI)获得研发资金的。该倡议的目标是推进美国国内的微电子设计,提高国防工业和国防部的安全性和获得尖端电子产品的机会。

“加快人工智能硬件的创新,以更快地在边缘做出决策”是ERI投资的重点之一。

领导Encharge AI的团队包括:

- Naveen Verma,普林斯顿大学电气和计算机工程师教授,其研究重点是新兴技术

- Kailash Gopalakrishnan,曾任IBM研究员,领导全球人工智能硬件和软件领域的工作

- Echere Iroaga,MACOM连接业务部门前副总裁兼总经理

内存计算

内存计算(IMC)似乎是EnCharge AI实现其效率和低功耗承诺的关键因素。该公司在其网站上列出了2019年、2020年和2021年的四份出版物,展示了他们在改进IMC以用于人工智能加速方面的研究进展。

他们最早的出版物指出,机器学习计算在很大程度上依赖于矩阵向量乘法(MVM),尽管数字加速器在能效和速度上比普通处理器提高了10-100倍,但这些收益主要来自计算,而不是所谓的“内存墙”——内存访问。在存储器之间移动数据在能量和时间上仍然具有高成本。

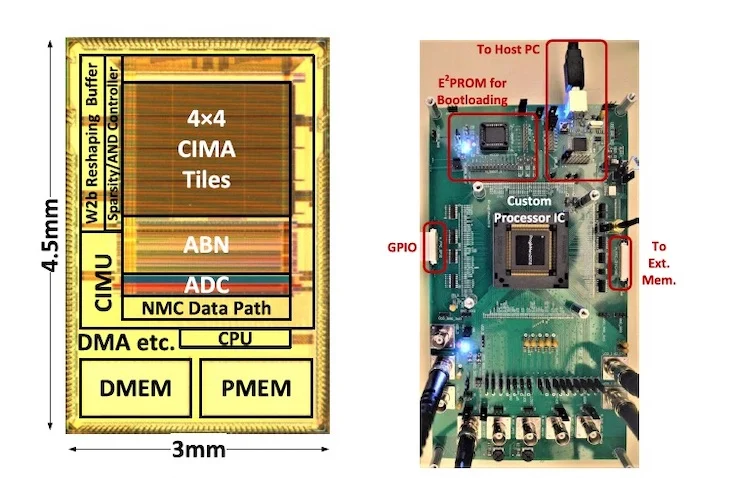

可编程、位可扩展的IMC架构:(a)异构微处理器架构,以及(b)用于神经网络训练和推理的软件库。(点击图片放大)

然而,IMC有一个折衷方案:虽然可以减少能量和延迟,但在读取存储器位线时,折衷方案是较差的信噪比(SNR)。SNR问题对异构系统中IMC的扩展提出了挑战,最有可能在现实世界的应用中使用。

2020年,该研究团队致力于解决信噪比问题,并开发了一种可编程的异构架构和利用电荷域IMC的软件堆栈。原型是基于65纳米CMOS。

这里展示的是原型系统。芯片图像65 nm CMOS微处理器上的图像(左)。用于芯片测试和应用演示的PCB(右)。

2021年,该团队引入了基于电容器的模拟计算,以改善从二进制矢量输入到5-b矢量输入的动态范围,并在共同设计算法以改善内存映射方面取得了进展。

前进的道路

据报道,EnCharge AI虽然前景看好,但尚未有客户排队。此外,还有一些相互竞争的公司已经做出了类似的承诺,并提供了大量资金。

欧洲公司Alexera AI就是这样一个例子,该公司于2022年10月宣布了2700万美元的A轮融资。与EnCharge人工智能一样,内存计算和流行的人工智能框架支持在他们的声明中占有重要地位。Alexera AI也有开发套件可供购买,Voyager SDK可供早期访问。

然而,与EnCharge AI不同的是,Alexera AI声称其效率为15 TOPS/W,而EnCharge人工智能的承诺为150 TOPS/W。

EnCharge AI提供的所有图像