工业相机加持为自驾赛车拓展视野

近年来自驾车已成为汽车产业的一大趋势。而机器视觉辨识是自驾车不可或缺的一部分,近期清华大学学生团队自行开发自驾赛车,兆镁新提供了工业相机及相关配备,协助团队达成目标...

近年来自驾车已成为汽车产业的一大趋势。而机器视觉辨识是自驾车不可或缺的一部分,近期清华大学学生团队自行开发自驾赛车,兆镁新提供了工业相机及相关配备,协助团队达成目标。

受到世界学生赛车(FSAE)启发,清大赛车工厂NTHU Racing于2015年成立,从零开始,自行设计和制作赛车,参与FSAE Japan,2018年转型制作电动车,并于隔年勇夺电动车第二名成绩,并获得最佳电子系统设计、效率奖等奖项。近年来,自动驾驶车已成为汽车产业的一大趋势。为求突破,清大学生团队开始自行开发自驾赛车,The Imaging Source 兆镁新(TIS)提供DFK 33UX273 相机以及相关配备,协助团队达成目标。

定位及建立地图资讯

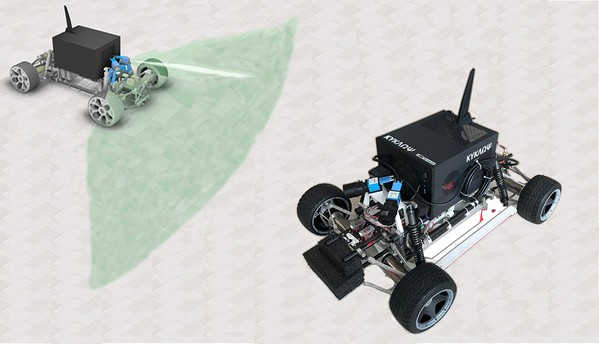

团队先制作一台缩小版赛车来测试硬体以及软体设计,团队目前开发的自驾系统由感测器融合与导航控制两部分构成,由角锥定义之赛道实现对应的定位及导航系统,藉此验证软体架构的可行性。

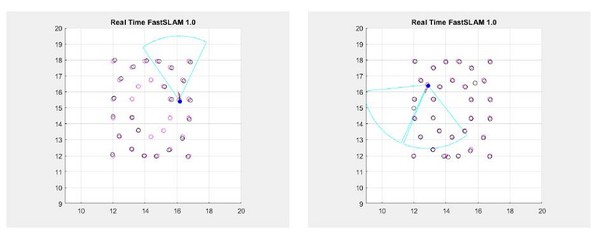

在测试过程中,感测讯号利用扩展卡尔曼滤波(EKF),与FastSLAM-1.0演算法融合机器视觉系统与各项感测器资讯,以估计出车辆定位与角椎地图资讯。导航控制则是基于定位与路径资讯,运算车辆动力学模型,以随机最佳化求解模型预测控制来达成车辆。

软体验证的方法融合了许多感测器类型的数据,如加速计、ToF以及视觉感测器。此感测器融合的过程可以达到最佳感测及导航控制。而视觉感测一直是无人车发展组成的一部分,用于可视化环境中的物体,如标志和车道标记,视觉数据也可用于解决任何自动驾驶车面临的另一个基本挑战:确定自己在三维空间中的位置的能力。

|

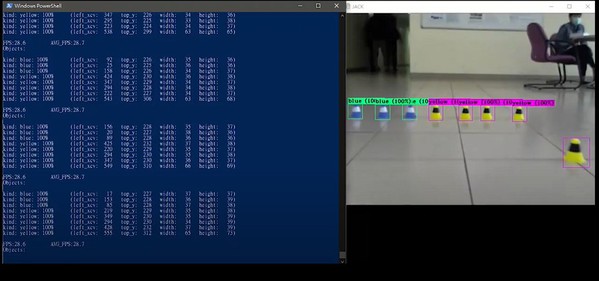

机器视觉辨识一直是自驾车不可或缺的一部分,有如无人车眼睛,帮助赛车在赛道上辨识且避开障碍,畅行无阻。一开始,学生安装单台USB 3.0 DFK 33UX273工业相机,整合成一个单相机系统。相机的输入被分析为环境资讯(例如黄色和蓝色的角锥,见图1),同时也用于帧对帧的视觉追踪。

|

相机的连续图像被用来估计车子本身相机的即时位置变化,进行单眼视觉测距(VO),然后使用扩展卡尔曼滤波(EKF)和FastSLAM-1.0演算法,测量环境的基本结构和几何形状。 然后,这些特徵匯集整合到一个视觉地图中,以高精度的方式预估汽车的位置(同步定位和建立地图资讯 ?SLAM)。

双眼看得比单眼广

在测试过程中,学生团队发现单台相机系统所提供的视野(FoV)还是有点太窄了(图2a),过程中仍然有一些死角,无法完整辨认全数角锥。

借鉴其他赛车队的经验,学生们决定测试在视觉系统中增加第二个相机,以增加视野并捕捉所有环境障碍物(图2b)。 在安装相机前,车辆仅能透过加速规和光流速度感测器来推估自身位置,但无法得知外在环境状况。经由USB 3.0相机能够快速有效地连接到计算机,将图像资讯从相机即时传输到资料库。经过测试,双相机系统便能成功辨识到所有角锥。

|

(b)增加第二台相机后的双相机系统拓展赛车的视野,也成功地捕捉到所有角锥的影像。