人工智能的未来是模拟的?新框架冲击模拟人工智能芯片规模

印度科学研究所(IISC)的研究人员描述了未来模拟人工智能芯片的框架,重新激发了对模拟芯片设计的需求。2022年7月6日,杰克·赫兹

随着该行业继续推动机器学习(ML)和人工智能(AI)的低功耗和高性能处理,大量新概念和技术占据了中心位置。其中,模拟计算作为一种更有效处理的令人兴奋的方法已经复兴。

尽管如此,对于这个特定的应用来说,这项技术还是相对较新的,而且还有很大的改进空间。本周,IISC的研究人员发表了一篇新论文,描述了未来可扩展模拟人工智能芯片的新框架。

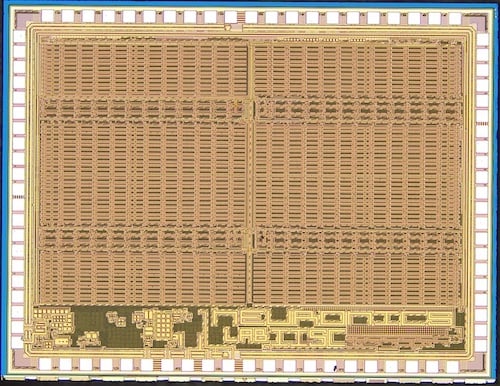

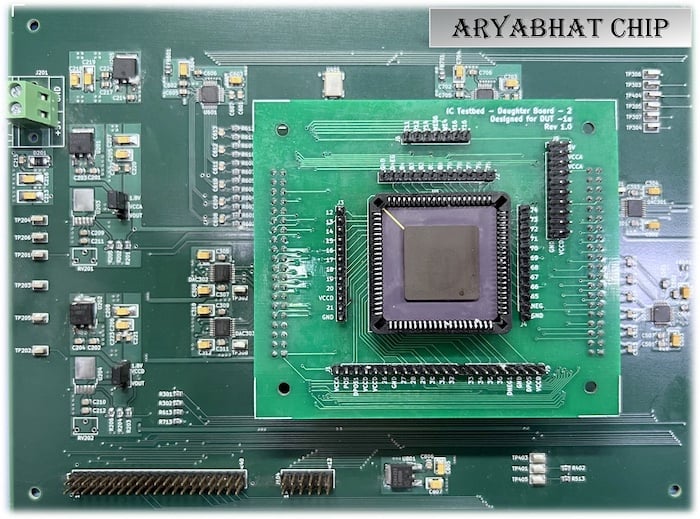

IISC的ARYABHAT-1芯片。图片由NeuRonICS实验室、DESE、IISc提供

本文将讨论模拟计算对人工智能的好处、该技术面临的一些挑战以及IISC的新研究。

为什么要转向模拟?

模拟计算是一种早于数字计算的技术,但随着数字技术的兴起,它在很大程度上被遗忘了。现在,研究人员再次关注模拟计算,这一次它似乎在几个方面击败了数字计算。

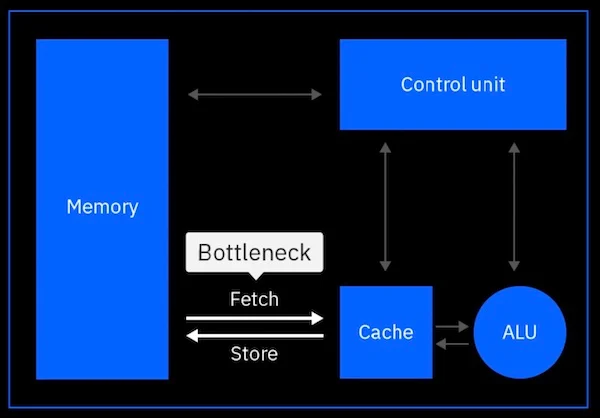

传统的冯·诺依曼体系结构受到数据移动的限制。图片由IBM提供

随着数据速率越来越快,处理节点越来越小,全球互连越来越长,该行业的一个新兴趋势是数据移动能量的显著影响。

寄生效应的增加导致了数据在内存中的物理移动,这已成为芯片整体功耗的最重要因素之一。再加上ML这一数据密集型应用程序,我们发现von Neumann架构不再适合AI/ML。

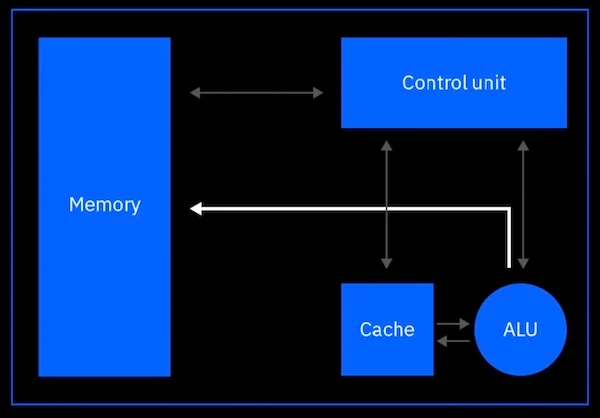

模拟人工智能将处理直接带入内存。图片由IBM提供

相反,模拟计算允许内存计算,在内存计算中,数据可以在存储的地方进行处理。主要好处是数据移动总体上显著减少,从而减少了总体能源支出。

通过这种方式,与用于AI/ML应用的传统数字电子设备相比,模拟人工智能可以提供高达100倍的功率效率提高。

模拟人工智能缩放面临的挑战

尽管模拟计算具有效率优势,但在成为数字计算的合法竞争对手之前,它仍然面临着一些挑战。

AI/ML模拟计算设计中的一个关键挑战是,与数字芯片不同,模拟处理器的测试和联合设计很困难。传统上,超大规模集成电路(VLSI)设计可以由数百万个晶体管组成,但工程师可以通过编译高级代码来综合设计。这种能力允许相同的设计在不同的过程节点和技术代之间轻松移植。

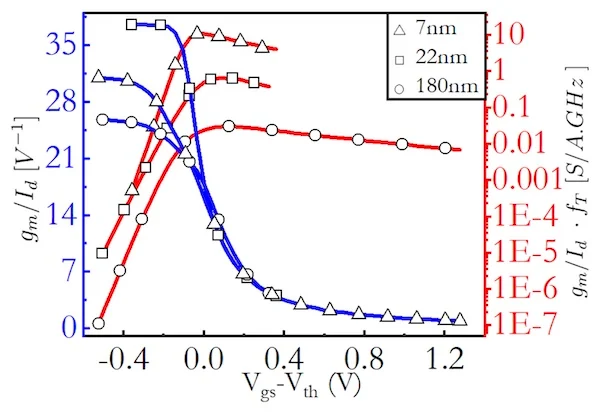

不同工艺节点的跨导(gm/Id)作为(Vgs–Vth)的函数。该图显示了轻松缩放模拟设计的挑战。图片由Kumar等人提供

然而,由于晶体管偏置状态、温度变化和有限的动态范围的差异,模拟芯片不那么容易扩展。结果是,每个新一代和流程节点都需要单独定制和重新设计。这一结果不仅使设计更加耗时和昂贵,而且还降低了可扩展性,因为向新技术的过渡需要更多的手工工作。

要使模拟人工智能成为主流,首先需要解决设计和可扩展性方面的挑战。

IISC的人工智能扩展框架

为了解决这个问题,IISC的研究人员在最近发表的论文中提出了一种可扩展模拟计算设计的新框架。

他们工作的关键概念围绕着裕度传播(MP)的推广,这是一种数学工具,以前在使用MP原理合成模拟分段线性计算电路方面显示出了价值。

出于这种概括,研究人员开发了一种新的基于形状的模拟计算(S-AC)框架,使研究人员能够近似ML架构中常用的不同函数。

基于所提出的模拟框架构建的芯片的测试设置。图片由NeuRonICS实验室、DESE、IISc提供

其结果是一个框架,可以像数字设计一样,成功地在精度与速度和功率之间进行权衡,也可以在不同的过程节点和偏置制度之间进行扩展。

作为概念验证,研究人员在几个不同的过程中实现了许多S-AC电路来表示ML中的常见数学函数。在这样做的过程中,研究人员成功地使用电路模拟来证明,在计划的180 nm CMOS工艺和7 nm FinFET工艺中,电路I/O特性保持合理的相同。

有了新的框架,研究人员希望在不久的将来创造出更具可扩展性和成本效益的模拟人工智能设计。