TinyML峰会:设计多模型智能HMI

在2023年TinyML峰会上,恩智浦提出了一种开发智能人机界面(HMI)的方法。2023年5月2日作者:杰克·赫兹

TinyML可以说是电子行业最热门、最重要的研究领域之一。TinyML峰会最近公布了2023届会议,供公众观看。继我们昨天的文章之后,我们又回到了TinyML峰会的另一个故事,这次的重点是恩智浦的演讲,题为“用微控制器设计多模型智能人机接口”,由恩智浦半导体产品经理Sriram Kalluri发表。

智能HMI将机器学习纳入标准HMI。图片由恩智浦提供

在本文中,我们将了解智能HMI、它们的挑战以及恩智浦演示的内容。

什么是智能HMI?

在我们理解恩智浦的演示之前,首先了解HMI和智能HMI的概念是很有帮助的。

人机界面(HMI)最好定义为人类用户通过其与一项技术进行交互的硬件和软件。对于大多数现代消费品,HMI将由LCD等图形以及触摸屏、鼠标和键盘等控制产品的技术组成。

另一方面,智能HMI试图通过向现有HMI注入智能功能来增强其功能。通常,智能人机界面将通过将机器学习模型纳入人机界面来添加计算机视觉(CV)、自动语音识别(ASR)或关键词检测等功能。例如,智能HMI可以是添加面部识别作为解锁设备的一种手段的智能手机。

人脸识别是一种可以作为ML驱动的智能HMI的一部分的功能。图像由恩智浦提供

正如Kalluri在演讲中解释的那样,“传统的HMI可能有一个图形显示器,然后基本上通过物理键或触摸进行交互。智能HMI的想法是,通过将语音控制、人脸识别和手势识别结合起来,使HMI更进一步。”

通过这样做,智能HMI使人机交互对用户来说更加直观和高效。

智能HMI的要求和挑战

一般来说,智能HMI有望用于智能手机或笔记本电脑等电池供电的消费设备。因此,在设计智能HMI时,主要目标是创造出同时具有非常高的性能、低延迟、功能丰富但功耗低的产品,以延长电池寿命。

根据Kalluri的说法,与同时实现所有这些要求相关的主要挑战与机器学习模型的实现有关。他指出:“在考虑这些需求的同时,出现的一个主要设计挑战是机器学习(ML)模型的实现和集成。通常,这些模型需要很高的初始投资,并且存在很大的进入障碍。”

此外,Kalluri指出,开发功能丰富的HMI应用程序可能非常昂贵和复杂。实现和合并ML模型。

恩智浦的解决方案利用ML模型

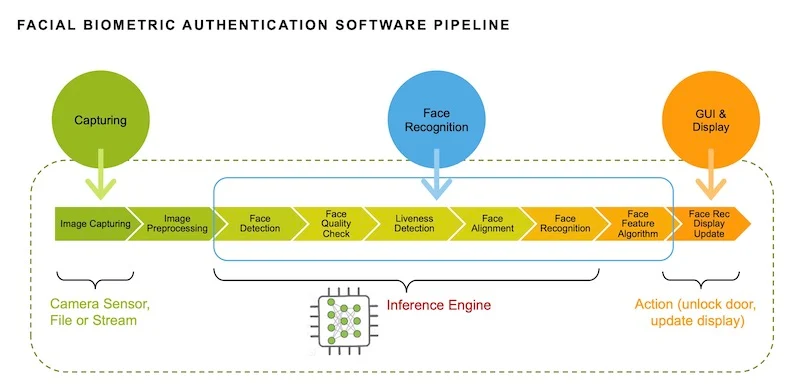

在他们的演示中,恩智浦展示了他们的解决方案,该解决方案包括5.5英寸LCD显示屏、通过恩智浦IW416的双频1x1 Wi-Fi 4+BLE连接、720p RGB图像传感器和数字麦克风。该解决方案使用专有软件管道将多个ML模型连贯地集成到一个智能解决方案中。这包括通过面部识别以及语音识别和控制来支持用户识别的机器视觉。

恩智浦解决方案的高级框图。图像由恩智浦提供。(点击图片放大)

要在本地低功耗运行所有这些算法,需要巧妙的软件设计和高效的硬件相结合。就硬件而言,该解决方案以NXP i.MX RT117H交叉MCU为中心,具有1 GHz Arm Cortex-M7内核和400 MHz Arm Cortex-M4内核。

Kalluri解释了硬件设置,并告诉观众:“我们用于智能HMI的硅是双核硅。我们在Cortex M-7上运行视觉和语音算法,而Cortex M-4驱动显示器并提供系统控制。”重要的是,该系统不需要任何专用DSP或加速器来运行本地算法。

让智能HMI更简单

通过他们的演示,恩智浦证明了智能HMI可以在边缘实现,进入门槛相对较低。他们的解决方案完全在MCU上运行,没有任何专门的硬件加速,并完全实现了功能丰富的HMI,提供面部识别、音频识别以及图形和手势控制。通过这一点,恩智浦希望让基于TinyML的智能HMI更容易被设计师访问和实现。